কৃত্রিম বুদ্ধিমত্তার তৈরি ডিপফেক ভিডিওর আদ্যোপান্ত

কোনো কিছু দেখার পর আমরা সেটা বিশ্বাস করি। সাধারণভাবে এমনটিই এতদিন হয়ে আসছিল। তবে এই ভাবনায় নতুন করে সন্দেহ জাগিয়েছে ডিপফেক। মানুষ এখন সহজেই কৃত্রিম বুদ্ধিমত্তা বা এআই-এর মাধ্যমে বিশ্বাসযোগ্য কিন্তু বানোয়াট ভিডিও তৈরি করতে পারছে। যেগুলো পুনর্লিখন করছে ইতিহাসের। পাশাপাশি ব্যবহার করা হচ্ছে মানুষকে প্রতারণার কাজেও।

যদিও আমরা বেশিরভাগ প্রতারণামূলক ছবির ক্ষেত্রে শেষ পর্যন্ত প্রমাণ করতে পেরেছি যে সেগুলো ভুয়া। তবে এই ক্ষেত্রে প্রযুক্তির একটি দিকের ক্রমাগত বিকাশ ঘটে চলেছে, আর মানুষকে বিভ্রান্ত করে চলেছে। সেটি হলো ডিপফেক পদ্ধতি। যা কোনটি আসল এবং কোনটি নকল তা জানার উপায়কে আরও কঠিন করে তুলেছে।

বর্তমানে ডিপফেক অনলাইন ভিডিওর প্রকৃতি পরিবর্তন করে ফেলছে। ডিপফেক আসলে কী এবং সেইসঙ্গে এই প্রযুক্তিটি আমাদের জন্য কীভাবে ঝুঁকিপূর্ণ হয়ে উঠছে তা নিয়েই আজকের আলোচনা।

ডিপফেক কী?

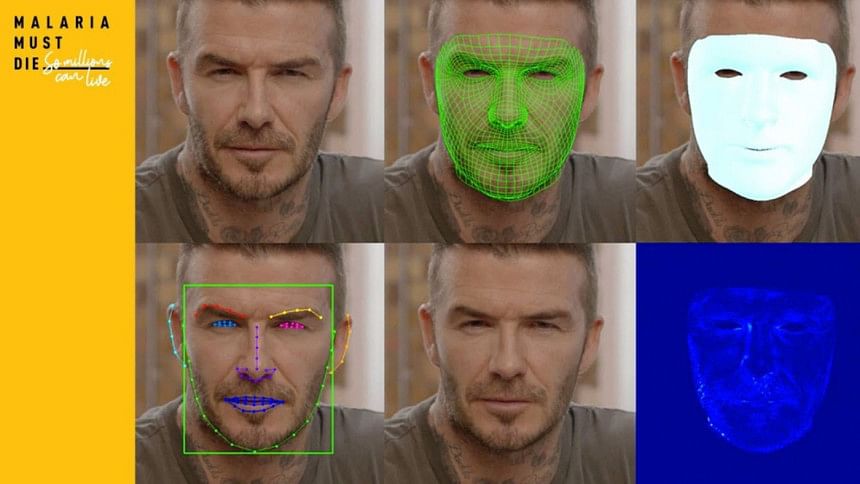

ডিপফেক শব্দটি এসেছে 'ডিপ লার্নিং' অর্থাৎ গভীরভাবে শিক্ষা নেওয়া এবং অন্যদিকে 'ফেক' অর্থাৎ নকল বা ভুয়া এই দুই শব্দের সংমিশ্রণ থেকে। ছবি এবং ভিডিও সংশ্লেষণে প্রশিক্ষিত এআই বা কৃত্রিম বুদ্ধিমত্তাযুক্ত সফটওয়্যার এই ভিডিওগুলো তৈরি করে থাকে।

সুতরাং ডিপফেকের সংজ্ঞা এভাবে দাঁড় করানো যায়, কৃত্রিম বুদ্ধিমত্তার মাধ্যমে কোনো ব্যক্তির নকল ভিডিও বা চিত্র তৈরি করা। যেখানে ব্যক্তিটির মুখ এবং কণ্ঠস্বর প্রতিস্থাপন বা নকল করতে কৃত্রিম বুদ্ধিমত্তা ব্যবহৃত হয়েছে। এই কৃত্রিম বুদ্ধিমত্তা কোনো একজন ব্যক্তি বা সাবজেক্টের মুখকে অন্য একটি ভিডিওর উপরে স্থাপন করতে পারে।

ইতোমধ্যে ডিপফেক প্রযুক্তির আরও উন্নত রূপগুলো কোনো ব্যক্তির মুখের নড়াচড়া, ছবি বা ভিডিও ব্যবহার করে যেকোনো বিষয়ের ওপর সেই ব্যক্তির সম্পূর্ণ নতুন মডেল তৈরি করতে পারে।

প্রযুক্তিটি শুধু একটি চিত্রের মতো সীমিত ভিজ্যুয়াল ডেটার ওপর ভিত্তি করেও মুখের মডেল তৈরি করতে পারে। তবে কৃত্রিম বুদ্ধিমত্তা যত বেশি ডেটা নিয়ে কাজ করতে পারবে, ফলাফল তত বেশি বাস্তবসম্মত হবে।

তাই রাজনীতিবিদ এবং সেলিব্রিটিরা ডিপফেকের সহজ শিকার হন। যেহেতু তাদের এমন অনেক ভিজ্যুয়াল ডেটা অনলাইনে সহজেই পাওয়া যায়। যা সফ্টওয়্যারটি ব্যবহার করতে পারে।

যেহেতু ডিপফেক সফটওয়্যারটি ওপেন সোর্স প্ল্যাটফর্মে পাওয়া যায়। তাই ইন্টারনেটে মানুষ এর ক্রমাগত পরিমার্জনের পাশাপাশি, অন্যদের করা পুরনো ডিপফেকের ওপর ভিত্তি করেও নতুন ডিপফেক তৈরি করছে।

ডিপফেকের উৎপত্তি

ডিপফেকের পেছনের প্রযুক্তিটি নানা উদ্দেশ্যে বিকশিত হয়। অনেকটা ফটোশপের মতোই এই সফটওয়্যারটিতে পেশাদার, বিনোদন এবং শখের জন্য ব্যবহারের মতো নানা দিক রয়েছে। আবার ফটোশপের মতোই সফটওয়্যারটি তৈরি করার পেছনে আসল নির্মাতাদের কোনো খারাপ উদ্দেশ্য না থাকা সত্ত্বেও এটি মানুষকে খারাপ উদ্দেশ্যে ব্যবহার থেকে বিরত রাখতে পারেনি।

ফেস-সোয়াপিং প্রযুক্তিটি প্রাথমিকভাবে চলচ্চিত্র শিল্পে ব্যবহৃত হয়। এর মধ্যে সবচেয়ে বিখ্যাত উদাহরণগুলোর মধ্যে একটি হলো ২০১৬ সালের চলচ্চিত্র 'রোগ ওয়ান: এ স্টার ওয়ার্স স্টোরি'। চলচ্চিত্রটিতে ফিল্মমেকাররা গ্র্যান্ড মফ তারকিন নামের চরিত্রটিকে পুনরায় তৈরি করতে ফেস-সোয়াপিং এবং ভিডিও সংশ্লেষণ প্রযুক্তির ব্যবহার করেছিলেন। চলচ্চিত্রটিতে প্রিন্সেস লিয়ারও একটি ছোটবেলার সংস্করণ তৈরি করা হয়। উভয় ক্ষেত্রেই আসল অভিনেতাদের মুখের মডেলগুলো স্ট্যান্ড-ইন অভিনেতাদের ওপর স্থাপন করে দেওয়া হয়েছিল।

স্ন্যাপচ্যাটের মতো অ্যাপগুলোর ব্যবহারকারীদের জন্য মজাদার ফিল্টার তৈরি করতে ফেস-সোয়াপিং প্রযুক্তির ব্যবহার করে। অ্যাপগুলোর ডেভেলপাররা এই ফিল্টারগুলোকে আরও কার্যকরভাবে প্রয়োগের জন্য, মুখ শনাক্তকরণ এবং ট্র্যাকিংকে ক্রমাগত পরিমার্জন করে থাকে৷

আবার অনেকে শিক্ষাগত উদ্দেশ্যে ভিডিও সংশ্লেষণের সরঞ্জাম তৈরি করেছে। যা দিয়ে তারা হলোগ্রাম তৈরি করছে। উদাহরণস্বরূপ, মুখের সংশ্লেষণ সফটওয়্যার দিয়ে তৈরি কোনো ভিডিও। যেখানে হলোকাস্ট থেকে বেঁচে যাওয়া ব্যক্তিদের সাক্ষ্য কোনো মিউজিয়ামে ইন্টারেক্টিভ হলোগ্রাম হিসেবে উপস্থাপন করা যেতে পারে।

ডিপফেক প্রযুক্তির দ্রুত উন্নয়ন

জীবনকে সহজ করে তুলতে মেশিন লার্নিং বেশ প্রয়োজনীয়। কিন্তু এ ক্ষেত্রে এটি নকল বা ভুয়া বিষয় তৈরির প্রক্রিয়াকে উল্লেখযোগ্যভাবে সহজ করে তুলছে। কৃত্রিম বুদ্ধিমত্তা দ্বারা তৈরি শিল্পকর্ম যেমন শিল্পে পরিবর্তন এনেছে। ঠিক তেমনি ডিপফেকগুলো অনলাইন ভিডিওর প্রকৃতিকেও পরিবর্তন করেছে। কিন্তু এর মধ্যে কিছু পরিবর্তন বেশ নেতিবাচকই বলা চলে।

প্রথমত, ডিপফেক সফটওয়্যার ব্যাপকভাবে এবং অবাধে পাওয়া যায়। উদাহরণস্বরূপ, ফেকঅ্যাপ সফটওয়্যারটি ডিপফেক তৈরির জন্য একটি জনপ্রিয় পছন্দ। এ ক্ষেত্রে একটি মুখ অদলবদল করার জন্য আপনার কোনো উন্নত দক্ষতার প্রয়োজন নেই। সফটওয়্যারটি আপনার জন্য তা সহজে করে দেবে।

যেহেতু কৃত্রিম বুদ্ধিমত্তা এবং ডিপ লার্নিং ডিপফেক তৈরিতে সাহায্য করে। তাই প্রযুক্তিটি ক্রমাগত উন্নত হচ্ছে। যার কারণে এর ভিডিওগুলো উদ্বেগজনক হারে আরও বিশ্বাসযোগ্য হয়ে উঠছে। বেশিরভাগ সময় এই সম্পাদনাগুলো খালি চোখে বোঝা যায় না। যার কারণে কোনটি আসল এবং কোনটি নয় তা বোঝা কঠিন হয়ে উঠে। তবে ডিপফেক শনাক্ত করার জন্য কিছু সুস্পষ্ট লক্ষণ এখনো রয়েছে। যেমন, এজ ক্লিপিং কিংবা নির্দিষ্ট কোণে মুখের বিকৃতি, ইত্যাদির দিকে লক্ষ্য করা।

ভুয়া খবরে ভরপুর বিশ্বে আমরা যা সত্য বলে মনে করি। তার বিরুদ্ধে বিশ্বাসযোগ্য ডিপফেক একটি বিশৃঙ্খল শক্তি হিসেবে মাথাচাড়া দিয়ে উঠতে পারে। আবার ডিপফেকের উত্থান এমন এক সময়ে ঘটছে। যখন এআই ভয়েস সংশ্লেষণ এবং এআই ভয়েস জেনারেটরগুলোরও অগ্রসর হচ্ছে।

কৃত্রিম বুদ্ধিমত্তা যে শুধু নকল ভিডিও তৈরি করতে পারে তা নয়। এটি মানুষের ভয়েস মডেলও তৈরি করতে পারে। এর মানে এই যে একজন রাজনীতিবিদের শব্দ বা কণ্ঠস্বর নকল করে কোনো আপত্তিকর বিবৃতি দেওয়ার জন্য এখন কোনো ছদ্মবেশীর প্রয়োজন হবে না। পরিবর্তে তাদের ভয়েস বা কণ্ঠস্বর নকল করতে কৃত্রিম বুদ্ধিমত্তাকে প্রশিক্ষিত করা সম্ভব।

ডিপফেকের পরিণতি

আপনি হয়তো বিনোদনমূলক ভিডিও তৈরির উদ্দেশ্যে ডিপফেক ব্যবহার করছেন। কিন্তু অনেকে খারাপ উদ্দেশ্যেও ডিপফেক ব্যবহার করছে। আপত্তিকর পরিস্থিতিতে সেলিব্রিটিদের ভুয়া ভিডিও তৈরি করতেও অনেকে ফেকঅ্যাপ ব্যবহার করছে।

তার ওপর বেশিরভাগ দেশে এই ধরনের বিষয়বস্তু নিয়ে এখন পর্যন্ত কোনো আইন নেই। যা এর নিয়ন্ত্রণ আরও কঠিন করে তুলছে। যদিও আমরা এখনো 'দ্য রানিং ম্যান' চলচ্চিত্রের মতো ভুল তথ্য এবং মিথ্যা ভিডিও প্রমাণ দ্বারা শাসিত ডিস্টোপিয়া থেকে কিছুটা দূরে রয়েছি। তবে আমরা ইতোমধ্যেই ভুয়া বা ফেক নিউজের প্রভাবগুলোর সঙ্গে খুব বেশি পরিচিত হয়ে উঠেছি।

রাজনৈতিক উদ্দেশ্যে ব্যবহৃত ডিপফেকের পরিণতি দ্বিগুণ। প্রথমত, এটি ভুয়া বা ফেক নিউজ ছড়িয়ে দেওয়াকে আরও সহজ করে তোলে। যেখানে মানুষ ইতোমধ্যেই কোনো প্রমাণ ছাড়াই বিভিন্ন ভুয়া ওয়েবসাইটের শিরোনামগুলো বিশ্বাস করে থাকে। সেখানে কাল্পনিক কিছু যে আসলে সত্যি সত্যি ঘটেছে। তা লেখা বা ছবির তুলনায় ভিডিও আরও সহজে মানুষকে বিশ্বাস করাচ্ছে।

মানুষকে বিভ্রান্ত করতে ব্যবহৃত ডিপফেকগুলোর অন্যতম একটি উদাহরণ হলো- ২০২২ সালের একটি ডিপফেক। যেখানে ইউক্রেনের প্রেসিডেন্ট ভলোদিমির জেলেনস্কি সৈন্যদের আত্মসমর্পণ করতে বলে এমন একটি ভিডিও তৈরি করা হয়। যদিও এটি ভুয়া বলে প্রমাণিত হয়। তবে ভিডিওটি এখনো সামাজিক যোগাযোগমাধ্যমে ছড়িয়ে আছে।

তবে রাজনীতিবিদরা বিভিন্ন দায়বদ্ধতা এড়াতে ডিপফেকগুলো নিজেদের কাজেও লাগাতে পারে। তারা সহজেই দাবি করতে পারে যে কোনো অডিও বা ভিডিও রেকর্ডিং আসলে ভুয়া, একটি ডিপফেক।

ডিপফেকের বিরুদ্ধে লড়াই

নিজেকে ডিপফেক ভিডিও থেকে রক্ষা করা বেশ কঠিন হতে পারে। তবে বিভিন্ন উপায়ে অনেক কোম্পানি ডিপফেক সহজে চিহ্নিত করার জন্য কাজ করছে। এক্ষেত্রে বিকৃত জাল ভিডিওগুলোর বিরুদ্ধে লড়াই করার জন্য বিভিন্ন টুল রয়েছে৷ ভিডিওতে টেম্পারিং শনাক্ত করতে এই টুলগুলোর মধ্যে অনেকগুলোই কাঁটা দিয়ে কাঁটা তোলার মতো কৃত্রিম বুদ্ধিমত্তাকেই ব্যবহার করে।

দ্য এআই ফাউন্ডেশন অনলাইনে ডিপফেক শনাক্তে সহায়তার জন্য রিয়ালিটি ডিফেন্ডার নামে একটি ব্রাউজার প্লাগইন তৈরি করেছে। সার্ফসেফ নামে আরেকটি প্লাগইনও অনুরূপ কাজ করে থাকে। এই দুটি টুলেরই উদ্দেশ্য হলো ইন্টারনেট ব্যবহারকারীদের মিথ্যা থেকে সত্যকে আলাদা করতে সাহায্য করা।

স্বনামধন্য ফ্যাক্ট-চেকিং ওয়েবসাইটগুলোও ভুয়া ভিডিও প্রতিহত করার লক্ষ্যে তাদের কার্যক্রম প্রসারিত করছে। ইতোমধ্যে মাইক্রোসফ্ট ডিপফেক ভিডিওগুলোর বিরুদ্ধে লড়াইয়ে সহায়তার জন্য নতুন প্রযুক্তি চালু করেছে।

এমনকি মার্কিন প্রতিরক্ষা বিভাগও ডিপফেক শনাক্ত করতে সফ্টওয়্যারে বিনিয়োগ করছে। তার কারণ, যদি কোনো বিশ্বনেতার কোনো বিশ্বাসযোগ্য ভিডিও অনলাইনে উপস্থিত হয়, তখন কী হবে? যেখানে অন্য দেশের বিরুদ্ধে যুদ্ধ বা ক্ষেপণাস্ত্র উৎক্ষেপণের ঘোষণা দেওয়া হয়। তাই কোনো ভিডিওর বৈধতা দ্রুত যাচাই করার জন্য সরকারের প্রয়োজনীয় সরঞ্জাম দরকার।

মেশিন লার্নিংয়ের অনিচ্ছাকৃত পরিণতি

এ ব্যাপারে কোনো সন্দেহ নেই যে কৃত্রিম বুদ্ধিমত্তার প্রযুক্তি এবং ডিপ মেশিন লার্নিং আমাদের জীবনকে বিভিন্ন উপায়ে সহজ ও উন্নত করছে। কিন্তু সবকিছুর মতোই প্রযুক্তিরও কিছু অনিচ্ছাকৃত পরিণতি রয়েছে। মানুষ ক্ষতির উদ্দেশ্যে কীভাবে কোনো প্রযুক্তি ব্যবহার করতে পারে তার ভবিষ্যদ্বাণী করা কঠিন। আর এই ক্ষেত্রে ডিপফেক-এর একটি উৎকৃষ্ট উদাহরণ।

তথ্যসূত্র: এমওইউ

গ্রন্থনা: আহমেদ বিন কাদের অনি

Comments